De todos los escenarios futuros que se barajan tras la irrupción de las inteligencias artificiales (IA) generativas tipo Dall-e 2, Midjourney y GPT-3 descarto los extremos. Ni creo que supongan el fin de los creativos, ilustradores y fotógrafos ni que sean un juguete pasajero que nos entretenga durante unos meses con resultados mediocres. Si tuviera que apostar, lo haría a que la creatividad del futuro va a ser asistida por inteligencia artificial. Diría que estos servicios, su evolución y las herramientas que veremos aparecer en los próximos años van a provocar una gran transformación que, como todas, va a tener ganadores y perdedores.

Este escenario sería uno en el que la IA puede ayudar en la ideación (ante un primer concepto que se nos pase por la cabeza, recibir un puñado de plasmaciones a las que no habríamos llegado por nosotros mismos) y traslada la pericia técnica relevante de unas habilidades a otras (cómo hablar a estas IA para obtener buenos resultados, cómo enfocar su desmesurado árbol de posibilidades y cómo combinarlas para destacar frente a los miles que simplemente mandan un texto y esperan un resultado). Al mismo tiempo, como toda faceta que se está digitalizando, corre el peligro de contaminarse de la lógica del Internet actual.

Para entender por qué puede suceder esto, tenemos que dar un paso atrás y observar cómo se consiguen estos asombrosos modelos. Para generarlos suele haber detrás una organización capaz de captar una cantidad masiva de datos (el dataset, imágenes para el caso que nos ocupa), filtrarlos, organizarlos y almacenarlos. Y todo eso cuesta dinero. Luego tiene que definir y entrenar el modelo de difusión, con un gran coste computacional. Y eso, con alguna excepción que veremos, cuesta mucho dinero.

No es de extrañar que los primeros modelos que se han podido utilizar vengan de organizaciones con mucha inversión y recursos (OpenAI) y que las que prometan resultados más espectaculares mientras se mantienen en cerrado estén en manos de gigantes tecnológicos, como Google y Facebook. El ideal para estas compañías es que la inteligencia permanezca en la nube (es decir bajo su autoridad en sus servidores) y se someta a un acceso controlado para poder decidir quién la utiliza, cómo y a cambio de cuánto dinero.

A eso sumaría que el momento de Silicon Valley (EEUU) para con su reputación es delicado, algo que ya va impactando con la libertad de información y de expresión. Así que, ante el potencial de estos servicios, han decidido poner una tonelada de venda antes de la herida. Si unimos su modelo preferido para el control y la maximización del retorno de la inversión con una cultura refractaria a la posibilidad de escándalos, cancelaciones y mala prensa tenemos un escenario en que la creatividad será asistida por inteligencia artificial y la inteligencia artificial será controlada.

El ejemplo de todo esto lo tenemos en el lanzamiento de Dall-e 2 de OpenAI. Es, de todos los servicios de generación de imágenes a partir de textos o de otras imágenes, el más llamativo por lo rápido que permite conseguir resultados de gran nivel (y que, por favor, no confundiría con Dall-E Mini, el de los memes). Empezó como una beta cerrada, es decir, una versión considerada todavía en desarrollo que sólo podía utilizar un pequeño grupo de usuarios seleccionados, que poco a poco fue aumentando. Con ello podían observar cómo se utilizaba el servicio y si había usos que ellos no desearan.

Lo que han ido descubriendo estos usuarios pioneros es que OpenAI tenía muy claro qué “palabras prohibidas” vetaría. De entrada, absoluta prohibición de todo lo relacionado con la evocación de violencia o sexo. También censura la integración en nuestras creaciones de famosos y el introducir nosotros mismas fotos con rostros reconocibles (un aspecto menos conocido de estos servicios es que pueden generar imágenes a partir de otras que utilizaríamos de base). El miedo de OpenAI radica en que Dall-e 2 se convierta en una herramienta para los deepfakes en los que Joe Biden aparece abrazado a Bin-Laden o que creemos imágenes con un conocido integrado en una escena porno. Y, como estos ejemplos, muchas más cortapisas y limitaciones.

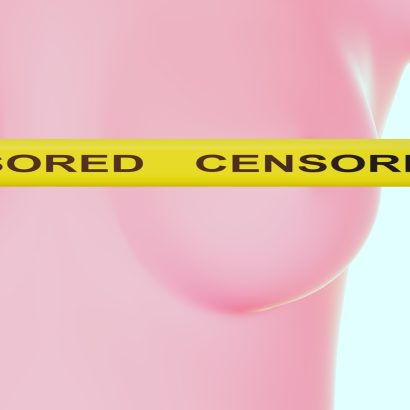

El control se extiende a escenas desagradables, por ejemplo “carne cubierta de gusanos”, o cualquier insinuación erótica. La creatividad para OpenAI será blanca e inmaculada, es el nuevo “no se pueden ver pezones de mujeres en Instagram”. Es más, en caso de hacer una petición que el sistema considere inadecuado, el usuario recibe un strike, una advertencia: si sigues por ese camino serás expulsado

Algo interesante en estos servicios tiene que ver con que la herramienta no es un folio en blanco, sino que está afectada por los datos con los que ha sido entrenada. Así es difícil hacer referencias culturales españolas actuales, mientras que las anglosajonas son de reproducción inmediata (se salvan Penélope Cruz y Antonio Banderas). Además, la salida también depende del aprendizaje de la IA: si ha sido entrenada con una base de datos de imágenes más los comentarios adyacentes en los que se llama “bella” a un tipo de mujer… cuando el usuario pida una “mujer bella” obtendrá un tipo muy concreto.

Dall-e 2 sabe que este tipo de dinámicas son un campo de minas reputacional que ya ha sido convenientemente controlado. Si pides una mujer bella, es probable que lo que obtengas por defecto rompa con la convención de “joven y delgada”. Si solicitas cualquier tipo de persona, en los resultados te ofrecerá una conveniente y sopesada diversidad racial. Para muchos se trata de un control necesario contra los estereotipos, para otros es un paternalismo colonialista: las grandes tecnológicas estadounidenses imponiendo con autoridad la ideología dominante en su país.

Este cuidado, control y dominación tiene mucho que ver con el estado de opinión respecto a las grandes tecnológicas y la conversación pública de masas, con la lucha por ser la ideología dominante y cómo se consigue, y poco con la idea de un arte que pueda ser transgresor y provocador. Esta vez nuestro pincel decidirá si lo que soñamos es conveniente que sea reflejado.

Por eso hay iniciativas a la contra de esta visión de relación de poder a través de otras herramientas creativas: proyectos como BLOOM, alternativa a LaMDA y GPT-3, y, sobre todo, Stable Diffusion. La sensación de las últimas semanas en la conversación tecnológica no lo es sólo por ser un Dall-e 2 de buen nivel, sino porque es un proyecto open source,en el que tanto el código como el modelo e incluso los datos de entrenamiento son (o serán) accesibles, y lo consigue a un coste mucho menor que los competidores.

Un servidor lo ha podido instalar en local, cambiar elementos del código y ejecutarlo en su propio ordenador. De repente mi creatividad ha dejado de depender de una gran corporación, su nube y sus reglas. Otros muchos están integrando, modificando y ampliando las posibilidades de Stable Diffusion, empujando una explosión de herramientas derivadas en un ciclo virtuoso que refleja lo mejor del compartir en tecnología. Seguiremos teniendo un lápiz para dibujar lo que queramos, pero la herramienta con la que en no mucho tiempo crearemos cuadros, fotografías, vídeos, cómics y experiencias interactivas que todavía hoy no alcanzo a imaginar serán software con inteligencia artificial. Decía Luis Buñuel en una cita apócrifa (que no he conseguido contrastar) que “si se puede pensar, su puede contar” en una reivindicación radical de la libertad creadora. Si no conseguimos que se imponga la opción abierta y libre que nos permita crear y que, aunque con costes y problemas derivados, nos deje transgredir y provocar, iremos a un mundo en el que el pincel y la máquina de escribir pondrán límites a la creatividad humana. Y dirán que lo hacen por nuestro bien.

Sobre la firma

Ingeniero Informático, pero de letras. Fundador de Xataka, analista tecnológico y escritor de la lista de correo 'Causas y Azares'