Después de un largo periodo de negociaciones en Bruselas, el Reglamento de Inteligencia Artificial ha iniciado la cuenta atrás para su completa aplicación en 2026. Con apenas dos años de transición por delante, gobiernos, empresas y organizaciones se enfrentan al reto de coordinarse para resolver los debates pendientes y aplicar de manera efectiva una regulación que marcará el futuro de la IA en Europa y probablemente, en el mundo.

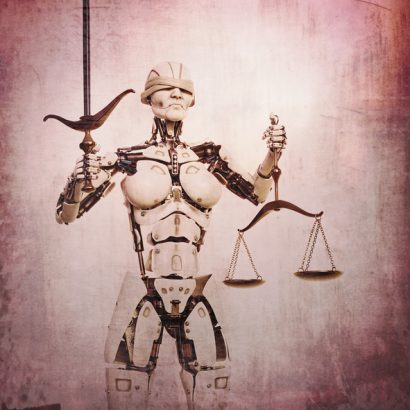

Uno de los objetivos del Reglamento es proteger a los ciudadanos europeos de los riesgos asociados a la IA. Estos riesgos incluyen, entre otros, los sesgos que pueden surgir en los algoritmos, afectando de manera injusta a ciertos grupos de personas. Esto ha abierto la puerta a un debate crucial sobre la justicia algorítmica, un campo de estudio que busca identificar y mitigar los sesgos que pueden surgir en los sistemas de IA, asegurando que actúen de manera equitativa, sin favorecer ni discriminar a ningún grupo, en función de características protegidas como género, etnia o edad. A medida que la IA se integra en áreas como la selección de personal, la concesión de créditos y la aplicación de políticas sociales, la urgencia de abordar este desafío se vuelve más necesaria que nunca.

Ya se ha demostrado que los sesgos en la IA pueden tener consecuencias reales y graves. Casos como el análisis de ProPublica sobre el sesgo racial en el sistema de justicia de EE. UU. y el escándalo de los beneficios de cuidado infantil en los Países Bajos, que evidenció el racismo institucional, resaltan la urgencia de abordar estas cuestiones.

Uno de los problemas más acuciantes es el de los sesgos existentes en los datos que alimentan estos sistemas. Estos sesgos pueden llevar a que la IA reproduzca o incluso amplifique discriminaciones preexistentes. Por ejemplo, si un sistema de selección de personal se entrena con datos que muestran una preferencia histórica por hombres en ciertos puestos, es probable que perpetúe esa tendencia, excluyendo injustamente a candidatas cualificadas.

Para abordar estos problemas, expertos en ética e IA han desarrollado estrategias de mitigación que se dividen en tres etapas: pre-procesamiento, procesamiento durante el entrenamiento y post-procesamiento. En la fase de pre-procesamiento, se busca asegurar una representación equitativa en los datos utilizados, ajustando, por ejemplo, la cantidad de hombres y mujeres en los conjuntos de datos de entrenamiento. Durante el entrenamiento, se ajustan los algoritmos para que reconozcan la necesidad de equidad en sus decisiones, en este caso, para que penalice las decisiones que reflejen desequilibrios de género. Finalmente, en la etapa de post-procesamiento, se corrigen los resultados para garantizar que no se reproduzcan desequilibrios.

Más allá de la mitigación de estos riesgos, el concepto de justicia exige debates profundos. ¿Es justo que un sistema de IA asegure la misma proporción de hombres y mujeres seleccionados para una entrevista? Es un dilema entre la igualdad de resultados y de oportunidades, que enfrenta la complejidad de equilibrar justicia, sesgos preexistentes y diversidad sin introducir nuevos sesgos o ignorar otras dimensiones importantes de la equidad. A medida que avanzamos hacia un futuro donde la IA juega un papel crucial en nuestras vidas, se vuelve vital diseñar sistemas de IA que objetivamente evalúen méritos sin sesgos, identificando y midiendo el «mérito» de manera justa en contextos variados y multidimensionales.

El concepto de justicia algorítmica trasciende su importancia ética para convertirse en un principio fundamental reconocido por instituciones internacionales como la OCDE o la UNESCO. Sin embargo, la adopción de este principio ético en la práctica requiere más que solo un compromiso teórico; necesita de un conjunto de herramientas de IA Responsable, que incluyen algoritmos específicos de justicia, metodologías y estándares de documentación. Estas herramientas son esenciales para cerrar la brecha entre los ideales éticos y la realización efectiva de una IA digna de confianza. Las bibliotecas de código abierto para el análisis de equidad o las plataformas de auditoría de sesgos son alguna alternativas para implementar principios de justicia algorítmica y ayudar a los desarrolladores a corregir desequilibrios en sus sistemas

Aunque estas herramientas probablemente no sean suficientes por sí solas, son un paso crucial hacia la creación de tecnologías que no solo sean avanzadas, sino que también tengan como objetivo ser justas y equitativas.

Desde Adigital, el certificado de inteligencia artificial responsable centrado en transparencia y explicabilidad de sistemas e IA guía a las empresas en el análisis de sesgos y les prepara para un análisis profundo de la justicia algorítmica tanto de sus sistemas como de sus modelos de IA. Este paso adelante de las empresas demuestra su compromiso hacia sus clientes y hacia la sociedad, mejora sus procesos de desarrollo estableciendo la responsabilidad como diseño y muestra de manera explícita el liderazgo de las empresas españolas y el uso real de la inteligencia artificial.

*Juliett M. Suárez es Manager de IA y Tecnologías Emergentes de Adigital y Justo Hidalgo es Director de Inteligencia Artificial de Adigital