Es curioso que la misma inteligencia artificial que promete revolucionar la educación aún tenga limitaciones tan básicas como no saber contar cuántas letras se repiten dentro de una palabra. En realidad, ChatGPT no las percibe como lo hacemos las personas, sino como una secuencia de números sobre los que analiza patrones y hace predicciones. Es decir, no cuenta las letras, sino que más bien «adivina» su número.

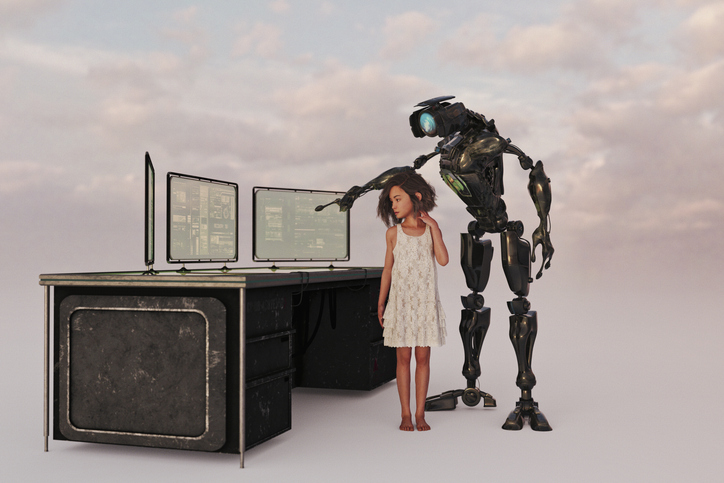

Esto no debería ser un impedimento para su uso en el ámbito educativo. De hecho, su potencial es tan amplio que sus límites parecen estar en nuestra imaginación. Por ejemplo, puede resumir capítulos, personalizar contenido o evaluar un trabajo destacando sus puntos de mejora. Ahora, todas estas oportunidades para potenciar el aprendizaje necesitan concretarse dentro del sistema educativo para lograr resultados tangibles.

De momento, no existe suficiente evidencia empírica sobre sus beneficios. La mayoría de los estudios se han centrado en el impacto de la IA en el ámbito empresarial, analizando cómo aumenta la productividad del empleado. Sin embargo, los que cuantifican su efecto en el proceso de aprendizaje son escasos.

El pasado julio, la Universidad de Pensilvania (Wharton) publicó una investigación con el elocuente título «La inteligencia artificial puede perjudicar el aprendizaje«. El estudio analizó el impacto del uso de chatbots inteligentes, como ChatGPT, en la resolución de problemas matemáticos en un grupo de 1.000 estudiantes. La conclusión, tal como anticipa el título del documento, es que no solo no facilita el aprendizaje, sino que podría obstaculizarlo.

Pero, ¿cómo es posible que los estudiantes no saquen provecho? ¿Qué lo está impidiendo? ¿Cuáles son las principales causas? Veamos algunas posibles explicaciones para este inesperado resultado:

- Las máquinas también se equivocan. Todos cometemos errores, y la IA no es una excepción. ChatGPT puede generar respuestas incorrectas, lo que se conoce como «alucinaciones«. Estos fallos van desde cálculos imprecisos hasta información inventada o un planteamiento del problema incorrecto. Para un estudiante que está aprendiendo, estos errores son difíciles de detectar y cuando se producen le generan confusión.

- No se puede distinguir qué tareas realiza con fiabilidad y cuáles no. No todas las tareas se les dan bien a las máquinas. Mientras que algunas las realizan con facilidad, en otras similares, e incluso más sencillas, la máquina no es capaz de llevarlas a cabo correctamente. Este fenómeno se conoce como la «frontera dentada de la IA”. El problema es que a pesar de que se le den mal, tiende a ser convincente. Esto mina la confianza de los estudiantes que no saben cuándo pueden confiar en su capacidad para llevar a cabo la tarea.

- El estudiante cree que adquiere conocimiento cuando no es así. A veces, la IA puede dar la impresión de que nos ha ayudado a comprender algo, cuando en realidad solo ha resuelto el problema por nosotros. Los estudiantes se crean un «espejismo de conocimiento«: creen que han entendido, cuando realmente no lo han hecho. Prueba de ello, es que cuando utilizan asistentes inteligentes se autoevalúan muy por encima de lo que más tarde consiguen en pruebas y exámenes.

- Automatizar tareas arrastra una pérdida de habilidades. Automatizar tareas puede ser útil, pero también tiene un coste. Actividades como resumir documentos, que requieren un esfuerzo por parte del estudiante, ahora se delegan en la IA. Esto puede erosionar su capacidad para sintetizar ideas, una habilidad clave durante el aprendizaje. Por cierto, según los últimos estudios, las máquinas son peores que los humanos haciendo resúmenes.

- Un exceso de “andamiajes” genera efectos adversos. En educación se entiende por andamiajes, aquellas herramientas que ayudan a los estudiantes a aprender con más facilidad. Sin embargo, cuando se recibe demasiada ayuda, como en el caso de un asistente personal tipo ChatGPT, puede producirse un efecto adverso dado que, el estudiante, deja de aprender de sus errores o de intentar diferentes aproximaciones antes de dar con la solución. Con el tiempo, esta dependencia perjudica el aprendizaje en lugar de fomentarlo.

Estos ejemplos muestran que los desafíos no son solo tecnológicos. De hecho, la innovación se produce a tanta velocidad, y los modelos avanzan tan rápido, que las dificultades actuales para realizar tareas básicas, como contar las letras dentro de una palabra, pronto estarán resueltas. OpenAI ya está desarrollando un nuevo proyecto denominado “Strawberry”, que promete incorporar mayores capacidades de razonamiento y lógica. La elección del nombre es un guiño a la dificultad de ChatGPT para contar el número de erres en la palabra “strawberry”, un ejemplo muy conocido entre expertos en IA.

Según OpenAI, los nuevos modelos podrán razonar de manera más humana, lo que podría aumentar su potencial en la educación, en especial en esa asignatura pendiente que son las matemáticas. Pero, por muy avanzada que llegue a estar esta tecnología, sigue siendo esencial entender el contexto de uso para saber cómo y cuándo emplearlas. Además, será necesario equilibrar el corto y largo plazo, ya que algunos efectos, como la pérdida de habilidades, no se ven de inmediato.

La IA ya forma parte de la realidad educativa, y no tiene sentido prohibirla o arrinconarla. Al contrario, se trata de utilizarla para reinventar el proceso de aprendizaje de los alumnos, aunque ello signifique volver a aprender a aprender.