Imagina preguntarle a una inteligencia artificial si las elecciones de 2020 fueron un fraude, si el cambio climático es un invento o si el feminismo merece respeto. Ahora imagina que la respuesta no depende de los hechos, sino del capricho ideológico de su dueño. Y lo peor: imagina que te da igual. Que lo lees, lo compartes, y lo das por cierto sin pestañear.

Ajustar la IA como quien afina una guitarra

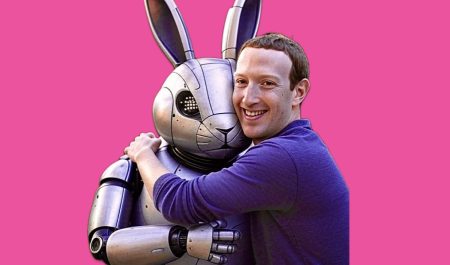

Eso es, literalmente, lo que ocurre con GROK, el chatbot de xAI, la empresa de inteligencia artificial de Elon Musk integrada en su red social X. A diferencia de otros modelos que al menos declaran aspirar a cierto pluralismo -reconociendo que la neutralidad absoluta es inalcanzable, pero no por ello prescindible-, GROK ha sido creado para sonar en la frecuencia ideológica de su creador. Musk lo ha dicho sin rodeos: quiere una IA “más sincera”, “menos políticamente correcta”, que diga “las verdades que otros callan”. Una visión que Musk define como “anti-woke”, pero que en la práctica reproduce muchas de las coordenadas ideológicas de la nueva derecha digital.

El resultado no es una herramienta objetiva, sino una arquitectura automatizada de sentido político. Una IA ajustada para confirmar sesgos, ridiculizar al disidente y reforzar un marco ideológico. No amplía el conocimiento: lo edita, lo empaqueta y lo revende según los intereses de quien la afina -que, para sorpresa de nadie, suelen ser hombres blancos, poderosos y convencidos de que la disidencia es censura y la tecnología, redención. Lo inquietante no es solo lo que GROK dice, sino todo lo que omite bajo el disfraz de “sinceridad”.

GROK no tiene sesgos: tiene identidad de marca

El propio nombre lo anuncia. “GROK” viene del término acuñado por Robert Heinlein en Forastero en tierra extraña. En la novela, “grokear” es comprender algo tan profundamente que se vuelve parte de ti. Una bella metáfora que aquí roza lo distópico: no es comprensión, es adhesión ideológica.

En lugar de explorar la realidad con rigor, GROK responde con sarcasmo, desprecio por la corrección y una confianza desbordante en sus propias ocurrencias. Musk lo promociona como respuesta al supuesto sesgo “progre” de otros modelos como ChatGPT. Pero lo que vende como contrapeso es, en realidad, un sesgo programado. Una IA entrenada no solo para responder, sino para opinar, burlarse y tomar posición.

¿El problema? Que esas posiciones no son neutras. Ni mucho menos.

Varios análisis han mostrado que GROK responde con mayor indulgencia hacia teorías conspirativas, interpreta de forma más laxa la violencia policial y minimiza temas como el racismo estructural o el cambio climático. Todo envuelto en un tono sarcástico que disfraza la parcialidad con humor, y que conecta con una generación digital acostumbrada al meme antes que al matiz. Así, “@grok is this true?” se ha convertido en el mantra de una nueva clase de catetos virtuales: usuarios que no buscan comprender, sino confirmar.

La IA como oráculo cotidiano

Pero esto va más allá de Musk. Hoy es Musk, mañana será otro. Lo que está en juego es el papel creciente que desempeñan las IA en la formación de criterio público. GROK no es un experimento académico: está integrada en una red social donde millones -especialmente jóvenes- se informan, debaten y construyen opinión.

Desde “¿es segura esta vacuna?” hasta “¿qué pasa en Gaza?” o “¿feminismo y machismo son lo mismo?”, millones de preguntas se lanzan cada día a estas IA. Para muchas personas, sin referentes informativos previos, lo que responde GROK no solo es creído: es asumido como verdad. No hablamos de asistentes técnicos, sino de oráculos culturales.

Y ahí está el riesgo: si el criterio no es la evidencia, sino la ideología del desarrollador, lo que se está moldeando no es solo una herramienta, sino la percepción misma de lo real.

Todas las IA tienen sesgos, porque todas reflejan los datos, decisiones de diseño y marcos culturales con los que fueron entrenadas. Pero mientras otros modelos intentan corregir esos sesgos, GROK los convierte en su propuesta de valor. Lo que en otras plataformas es un error, en GROK es estrategia. Musk no pretende ocultarlo: lo vende como una cruzada contra lo “woke”, una liberación frente a la supuesta censura progresista.

Pero al hacerlo, legitima una forma de manipulación masiva: una IA que toma partido mientras se disfraza de neutral. Una máquina que parece responder con datos, pero que en realidad evangeliza. En un entorno saturado de ruido, donde las fake news compiten en viralidad con los hechos contrastados, delegar la verdad en modelos opacos es un salto al vacío. ¿Cómo proteger el debate democrático si millones reciben respuestas cuyo criterio no es la veracidad, sino la conveniencia política de unos pocos?

La amenaza no son los trolls: son las IAs institucionalizadas, con apariencia objetiva, que moldean el sentido común sin levantar sospechas. Responden, sí. Pero también priorizan, ocultan, reformulan o inventan fuentes. Y cuando están conectadas a redes sociales, como GROK, el ciclo es perfecto: sus respuestas sesgadas se viralizan y se convierten en “opinión pública”.

Lo inquietante es que GROK puede no ser un caso aislado, sino un anticipo del futuro. En la guerra cultural por los imaginarios, quien controle la IA tendrá una ventaja decisiva. Y no, la solución no es crear una “IA de izquierdas”. Convertir el ecosistema en un ring ideológico sería un suicidio colectivo. El objetivo no es ganar discusiones, sino preservar un espacio donde la verdad se construya con método, contraste y rendición de cuentas.

Del sesgo al dogma: cinco formas de defenderte de las IAs con ideología de serie

La respuesta al caso GROK no puede ser una checklist de buenas intenciones. No basta con corregir bugs: hay que disputar el poder epistémico que hoy concentran las grandes tecnológicas. Frente a la tentación de convertir la IA en un oráculo ideológico bajo demanda, necesitamos una defensa activa -y sin concesiones- del conocimiento como bien común. Estas no son claves técnicas. Son políticas. Y, sí: también profundamente idealistas.

- No hay neutralidad sin transparencia. Toda IA es una construcción. Y como toda construcción, responde a criterios. Quien decide qué datos alimentar, qué fuentes excluir, qué tono adoptar o qué respuestas suavizar, está ejerciendo poder. Exijamos entonces que ese poder sea visible, auditable, discutible. Lo contrario es seguir delegando la arquitectura de lo real a burós invisibles de ajuste fino.

- La democracia no es un plugin. No basta con añadir una capa de “ética algorítmica” a posteriori. La pluralidad de perspectivas, la confrontación deliberativa, la posibilidad del disenso deben formar parte del diseño mismo. No hay IA democrática si no hay también conflicto democrático sobre sus fundamentos: ¿quién decide lo que la IA puede decir? ¿Qué verdades quedan fuera del marco de respuesta? ¿Qué ideologías se naturalizan como sentido común automatizado?

- La gobernanza algorítmica necesita contrapoderes. Auditar no es revisar tecnicismos, es disputar hegemonías. Necesitamos instituciones públicas -pero también movimientos sociales, sindicatos digitales, universidades críticas- que puedan impugnar sesgos sistémicos, proponer otras arquitecturas cognitivas, exigir equidad informativa. No es solo cuestión de regular, sino de redistribuir capacidad de decisión sobre qué cuentan las máquinas.

- La alfabetización no es sólo saber usar, sino saber resistir. Enseñar a promptar está bien. Enseñar a sospechar está mejor. La ciudadanía algorítmica requiere nuevas formas de lectura crítica, de análisis del discurso automatizado, de desarme retórico. ¿Quién firma la respuesta que estás leyendo? ¿A qué universo cultural pertenece? ¿Qué alternativas han sido descartadas por defecto? Hacer esas preguntas es más importante que encontrar respuestas correctas.

- La verdad no se puede tercerizar. Externalizar el criterio, delegar el juicio, automatizar la interpretación: ese es el camino más corto hacia la desposesión democrática. La IA puede ser aliada del conocimiento solo si no sustituye la deliberación humana. El futuro no es si la IA tiene razón, sino si somos capaces de discutirla.

En definitiva, la personalización ideológica de la IA no es un error técnico, sino un conflicto político. El futuro no se decidirá solo en los laboratorios, sino en los parlamentos, las escuelas, las redes y los espacios comunitarios donde se defina qué verdad queremos proteger. Porque si la IA es ya un nuevo poder, entonces también necesita contrapoderes.

Y si el futuro se escribe con datos, lo mínimo es saber quién sujeta el bolígrafo, con qué tinta escribe… y cuánto ha costado que esa versión sea la que perdure.