Aquellos que pueden hacerte creer absurdos, pueden hacerte cometer atrocidades

Voltaire

Desde el Siglo de las Luces, el pensamiento crítico ha sido una herramienta fundamental para combatir la manipulación informativa. Voltaire, con su feroz crítica al dogmatismo y la censura, alertó sobre los riesgos de una sociedad en la que unos pocos controlan la información. Hoy, en la era digital, no son monarcas ni líderes religiosos quienes moldean la opinión pública, sino los algoritmos de las grandes plataformas tecnológicas.

Con el inicio de 2025, el Foro Económico Mundial ha vuelto a señalar la desinformación como uno de los riesgos más significativos a nivel mundial. La Unión Europea y Organismos Internacionales como las Naciones Unidas también han expresado su preocupación. Desde Bruselas, se está impulsando lo que han denominado “un escudo contra la desinformación”, que incluirá equipos de verificadores y regulaciones más estrictas para evitar la manipulación de la opinión pública por actores externos.

Sin embargo, en el mismo Foro y desafiando el consenso internacional, Donald Trump irrumpió con una postura radicalmente opuesta: “Nuestro gobierno ya no etiquetará a nuestros propios ciudadanos como ‘información errónea’ o ‘desinformación’, que son las palabras favoritas de los censores y de aquellos que desean detener el libre intercambio de ideas”, declaró el nuevo presidente estadounidense

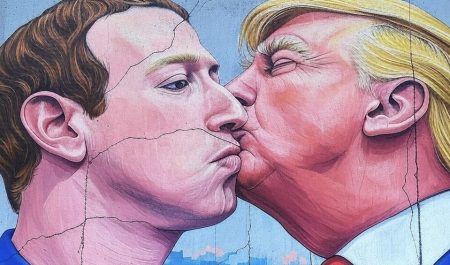

Trump no está solo. Pocos días antes, durante su toma de posesión, se le pudo ver rodeado de figuras clave del mundo tecnológico: Elon Musk (X), Mark Zuckerberg (Meta), Sam Altman (OpenAI), Jeff Bezos (Amazon), Tim Cook (Apple) y Sundar Pichai (Google), algunos de los cuales han manifestado abiertamente su apoyo a su enfoque. Como ejemplo, Zuckerberg anunció la adopción de un modelo inspirado en las «Community Notes» de X (antes Twitter), prescindiendo de los verificadores de contenidos de Meta que llegaron a ser 30.000 personas en su momento de máximo apogeo. Por su parte, Musk, un firme defensor de la autorregulación de los usuarios, sostiene que solo así se garantizará la libertad de expresión en internet.

El mensaje es claro: la tecnología y el poder político han unido fuerzas para redefinir la relación entre las plataformas digitales y la desinformación. La nueva norma es la ausencia de normas, delegando en los usuarios la tarea de discernir la verdad en un ecosistema donde las fronteras entre la realidad y la manipulación son cada vez más difusas.

Este cambio de paradigma se enfrenta al modelo europeo, que apuesta por una moderación más estricta y equipos de verificadores profesionales. Hasta el momento, plataformas como YouTube, TikTok y LinkedIn han mantenido sus políticas de moderación, pero la creciente presión del sector podría llevar a que adopten modelos de autorregulación similares al de X y Meta. La pregunta que surge es: ¿cuánto tiempo resistirán antes de ceder a esta nueva dinámica?

Mientras estas decisiones redefinen la dinámica de las redes sociales en democracias occidentales, también están alterando los principios fundamentales sobre los cuales se ha construido el orden democrático moderno. A su vez están generando un impacto global que afecta a todos, erosionando las instituciones que garantizan el acceso a la información.

La desinformación avanza sin barreras en el Sur Global, debilitando instituciones y agravando la crisis de muchos de estos países. Este efecto es aún más preocupante en contextos donde gran parte de la población es analfabeta y las fuentes confiables escasean, facilitando la propagación de información falsa sin mecanismos efectivos de control.

Aunque en las siguientes secciones del artículo analizaremos en más detalle el empleo de la desinformación en contextos específicos, históricos y su impacto, cabe mencionar, por citar algunos ejemplos, cómo Brasil y México han sido particularmente afectados recientemente con olas masivas de noticias falsas durante procesos electorales, exacerbando la polarización y la desconfianza en las instituciones. O cómo, en África, la desinformación también ha sido un factor clave en crisis sanitarias, como en la gestión del ébola en la República Democrática del Congo, donde rumores infundados dificultaron la respuesta médica.

Según indican las conclusiones del informe de la OCDE de 2024 sobre desinformación, “la difusión de información falsa y engañosa genera confusión y polarización, sembrando desconfianza y socavando los procesos democráticos”. En el sudeste asiático, el impacto de la desinformación ha sido igualmente significativo. Países como Filipinas y Myanmar han visto el uso estratégico de redes sociales para manipular la opinión pública, mientras que en el Medio Oriente, la desinformación se ha consolidado como un arma de propaganda en conflictos prolongados, como los de Siria y Yemen.

Tres ejemplos específicos que ilustran el peligro mortal de la desinformación son: la propagación de noticias falsas sobre vacunas y autismo que ha llevado a brotes de enfermedades prevenibles, los rumores en WhatsApp que provocaron linchamientos fatales en India, o las falsedades sobre fraude electoral en Estados Unidos—que todavía muchos cuestionan a día de hoy—desencadenaron el violento asalto al Capitolio en 2021.

Las “Community Notes” son un sistema de verificación colectiva donde los propios usuarios añaden contexto y señalan inexactitudes en las publicaciones. La idea es que la comunidad ejerza de “editor” y corrija datos engañosos. Sin embargo, depende de la participación activa de distintos perfiles ideológicos y de la voluntad de los usuarios para revisar y aceptar correcciones, lo cual puede verse afectado en entornos polarizados.

¿Serán realmente eficaces los sistemas de autorregulación basados en community notes que impulsan Trump, Musk y Zuckerberg para combatir la desinformación?

Un estudio publicado en Journal Information Systems Research concluyó que estas notas reducen la difusión de noticias falsas en temas como la salud, disminuyendo la interacción con publicaciones engañosas por parte de usuarios reales. Sin embargo, investigaciones más recientes señalan algunas limitaciones: en contextos polarizados como la política, las notas suelen ser menos efectivas debido a la falta de consenso entre usuarios de diferentes ideologías.

Un estudio del Instituto Poynter, por ejemplo, reveló que durante las elecciones estadounidenses de 2024, las Community Notes tuvieron un impacto marginal en la mitigación de la desinformación electoral. El cofundador de Twitter, Jack Dorsey, destacaba la importancia de la confianza del público en los esfuerzos de verificación de hechos. Sin embargo, investigadores como Jean Burgess y Ariadna Matamoros-Fernández advierten en un estudio sobre verificación colaborativa que este enfoque tiene una eficacia limitada frente a narrativas complejas. Su analisis muestra que la aplicación efectiva de estas verificaciones es baja: solo el 29% de los tuits verificables reciben notas útiles. Esto sugiere que, aunque la verificación masiva puede ser una herramienta valiosa, está lejos de ser una solución definitiva contra la desinformación.

Esta posición de autorregulación radical también refuerza la influencia directa de los líderes tecnológicos en la esfera pública. Políticos afines pueden beneficiarse al difundir mensajes sin restricciones, mientras que grupos opositores pueden perder visibilidad. Las consecuencias abarcan desde el refuerzo de narrativas extremistas hasta la erosión de la confianza en los procesos electorales, alimentando la polarización y generando un caldo de cultivo para conflictos sociales.

¿Cómo hemos llegado hasta aquí?

En dos décadas, los algoritmos han evolucionado de recomendar contenido basado en los gustos de los usuarios (“si te gusta esto, quizás te guste esto”) a priorizar las emociones más intensas —indignación, miedo, entusiasmo—, alimentando narrativas polarizantes que maximizan la atención a menudo a costa de la veracidad del contenido y, en muchos casos, del bienestar mental de los usuarios. Pero esta transformación no solo ha cambiado la forma en que nos relacionamos con la información, sino también quién la controla y bajo qué criterios.

Más que simples herramientas tecnológicas, estos sistemas han adquirido la capacidad de reconfigurar el debate público y moldear nuestras percepciones colectivas. En España, según los Estudios Generales de Medios (EGM) de la AIMC durante 2024, solo el 13,5 % de la población leyó prensa de papel y alrededor de un 30% otros medios incluyendo televisión y medios digitales, mientras que casi un 80 % se conectó a redes sociales.

En Estados Unidos, según el Pew Research Center, el 86 % se informa principalmente a través de dispositivos móviles. El 63% se informa a través de la televisión, mientras que solo el 26% lo hace mediante publicaciones impresas. Entre quienes utilizan dispositivos digitales, un 50% obtiene información directamente de redes sociales. Esta transición no ha sido solo tecnológica, sino también editorial: las plataformas han pasado de ser intermediarios neutrales a convertirse en curadores de contenido, determinando qué temas ganan visibilidad y cuáles quedan relegados en el ruido digital.

La cuestión clave es: ¿quién selecciona el menú de contenidos en estas plataformas? Si antes los periódicos y medios tradicionales tenían líneas editoriales explícitas, hoy los algoritmos de recomendación operan como editores invisibles, modulando la conversación pública sin asumir responsabilidad alguna. ¿Qué deciden favorecer como marco de la conversación y en detrimento de qué? ¿Tienen los algoritmos “líneas editoriales” comparables a las de los medios de comunicación? ¿Pueden identificar la información como falsa?

Estas preguntas reflejan una realidad ineludible: el acceso a la información ya no es un derecho neutral, sino un producto moldeado por intereses económicos, políticos y tecnológicos. En este ecosistema, la verdad se ha vuelto un bien disputado, y su control, una herramienta de poder sin precedentes.

Se ha creado un ecosistema que puede distorsionar la percepción de la realidad y también contribuir a la erosión de la confianza en las instituciones democráticas y en el sistema judicial, socavando la base misma del Estado de Derecho.

Los datos del barómetro de confianza Edelman 2024, reconocida encuesta anual que mide la confianza del público en instituciones como empresas, gobiernos o medios de comunicación, confirman algo que podemos palpar en las calles: estamos viviendo en una auténtica crisis de confianza. La totalidad de la población mundial es más pesimista sobre el futuro que en años anteriores. En países como Japón, Francia, Holanda, Canadá o España solo entre el 6 y el 28 % de la población cree que las cosas irán a mejor: un 70% de la población tiene una visión pesimista sobre el futuro.

2025 podría marcar un punto de inflexión en esta espiral de desconfianza y polarización, impulsada por la creciente influencia de algoritmos en la opinión pública. Las recientes políticas tecnológicas no solo consolidan un cambio estructural en las plataformas digitales, sino que también abren la puerta a una realidad en la que la realidad podría ser el mayor sacrificio en el altar del «engagement» si no se aplican otras medidas adicionales. Si la desinformación sigue normalizándose como parte del ecosistema digital, corremos el riesgo de que la polarización y el cinismo desplacen a la confianza y el pensamiento crítico en la esfera pública y donde el estado de derecho podría verse desbordado por la fragmentación social y la pérdida de legitimidad institucional.

¿Podría la misma inteligencia artificial que alimenta estos algoritmos ofrecer una solución al problema que ha ayudado a crear? ¿Podría el desarrollo de nuevas habilidades humanas combinadas con políticas de transparencia reformular este momento? ¿Estamos preparados para defender el Estado de Derecho en la era digital o aceptaremos la erosión de los principios democráticos y la confianza como un daño colateral del avance tecnológico?

Independientemente de las preguntas que nos hagamos o de los daños que estemos dispuestos a aceptar en nombre del progreso digital, la reflexión inicial de Voltaire la reflexión inicial de Voltaire con la que iniciamos este artículo, el primero de una serie de tres que completarán este análisis sobre los limites en la era digital, nos conduce a una cuestión aún más profunda: ¿qué es y qué significa la realidad en este nuevo ecosistema? ¿Que es información y que es desinformación y cómo podemos discernirlo?

En la siguiente entrega exploraremos cómo el poder de los algoritmos ha cambiado nuestra relación con la información y su impacto, realizando también un breve análisis histórico de la desinformación, desde los sumerios hasta nuestros días.

* Víctor Gay Zaragoza es profesor en IE Business School y fundador de The Yellow Way, una empresa especializada en storytelling y visual data storytelling. Sus proyectos combinan narrativa, comunicación visual y estrategias persuasivas para transformar la manera en que las organizaciones comunican datos e ideas, colaborando con empresas como Repsol, Telefónica, Escribà, Accenture y la Cruz Roja.

* Miguel Alexandre Barreiro-Laredo es investigador en el MIT, profesor en IE University y asesor del Programa de las Naciones Unidas para el Desarrollo (PNUD) en la Unidad de Respuesta a Crisis. Sus proyectos combinan tecnología, sostenibilidad y empoderamiento comunitario para mitigar riesgos climáticos, conflictos sociales y promover economías inclusivas.